Talaan ng mga Nilalaman:

- May -akda Lynn Donovan [email protected].

- Public 2023-12-15 23:54.

- Huling binago 2025-01-22 17:43.

Upang paganahin ang Spark history server:

- Gumawa ng direktoryo para sa mga log ng kaganapan sa DSEFS file system: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events.

- Kapag pinagana ang pag-log ng kaganapan, ang default na gawi ay para sa lahat ng mga log na i-save, na nagiging sanhi ng paglaki ng storage sa paglipas ng panahon.

Sa tabi nito, paano ako magse-set up ng spark History server?

Upang paganahin ang Spark history server:

- Gumawa ng direktoryo para sa mga log ng kaganapan sa DSEFS file system: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events.

- Kapag pinagana ang pag-log ng kaganapan, ang default na gawi ay para sa lahat ng mga log na i-save, na nagiging sanhi ng paglaki ng storage sa paglipas ng panahon.

Katulad nito, paano ko mahahanap ang URL ng server ng aking spark History? Hal., para sa server ng kasaysayan , karaniwang maa-access ang mga ito sa server - url >:18080/api/v1, at para sa tumatakbong application, sa https://localhost:4040/api/v1. Sa API, ang isang application ay tinutukoy ng application ID nito, [app-id].

Gayundin, ano ang server ng spark History?

Ang Ang Spark history server ay isang tool sa pagsubaybay na nagpapakita ng impormasyon tungkol sa natapos Spark mga aplikasyon. Ang impormasyong ito ay kinuha mula sa data na isinulat ng mga application bilang default sa isang direktoryo sa Hadoop Distributed File System (HDFS).

Ano ang Sparkui?

Binibigyang-daan ka ng Spark Web UI na makakita ng listahan ng mga yugto at gawain ng scheduler, impormasyon sa kapaligiran, impormasyon tungkol sa mga tumatakbong tagapagpatupad at higit pa. Panoorin ang 30 minutong demo na ito upang malaman ang tungkol sa: Mga bahagi at lifecycle ng isang programang Spark. Paano tumatakbo ang iyong Spark application sa isang Hadoop cluster.

Inirerekumendang:

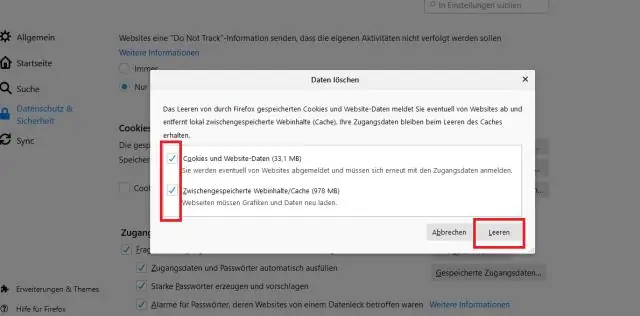

Paano ko tatanggalin ang aking UC browser history mula sa aking computer?

Mag-click sa icon ng gear ng Mga Setting sa toolbar ng UCBrowser. Mag-scroll pababa sa 'I-clear ang Mga Tala' at pindutin ito. Bibigyan ka na ngayon ng opsyon na i-clear angCookies, Form, History, at Cache. Siguraduhing ang 'History' ay na-tick at pindutin ang Clearbutton

Paano ko sisimulan ang aking JVC TV?

Video ng Araw Alisin sa saksakan ang JVC mula sa saksakan ng kuryente sa loob ng 10 segundo. Isaksak muli ang JVC TV sa poweroutlet. Pindutin nang matagal ang parehong 'Menu' at 'Volume Down (-)' na button para sa isa pang 10 segundo. Bago ilabas ang mga nabanggit, pindutin nang matagal ang 'Power'button

Paano ko sisimulan ang aking CPU sa safe mode?

I-tap ang F8 key sa tuluy-tuloy na bilis habang nagbo-boot ang computer, hanggang sa lumabas ang menu ng Windows Advanced Options. Gamitin ang mga arrow key upang ilipat ang highlight bar sa opsyon na Safe Mode na matatagpuan sa tuktok ng menu. Kapag na-highlight na ito, pindutin ang Enter

Paano ko sisimulan ang aking Lenovo g500 sa safe mode?

Pindutin nang matagal ang Shift key habang nagki-click sa I-restart mula sa Shut down o sign out na menu. Piliin ang I-troubleshoot> Mga advanced na opsyon> Mga Setting ng Startup>I-restart.Pagkatapos mag-restart ang PC, mayroong isang listahan ng mga opsyon. Piliin ang 4o F4 o Fn+F4 (pagsunod sa mga tagubilin sa screen) upang simulan ang PC sa Safe Mode

Paano ko sisimulan ang aking Raspberry Pi 4?

Ikonekta ang keyboard, mouse, at monitor cable Ikonekta ang keyboard. Ikonekta ang isang regular na wired na PC (o Mac) na keyboard sa isa sa apat na mas malaking USB A socket sa isang Raspberry Pi 4. Ikonekta ang isang mouse. Ikonekta ang isang USB wired mouse sa isa sa iba pang mas malalaking USB A socket sa Raspberry Pi. Ikabit ang micro-HDMI cable