- May -akda Lynn Donovan [email protected].

- Public 2023-12-15 23:54.

- Huling binago 2025-01-22 17:43.

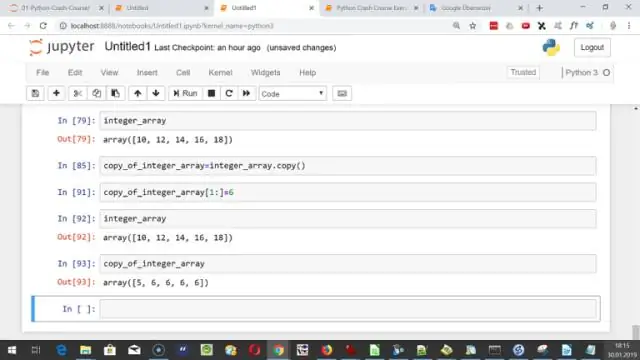

Hindi, ayaw mo kailangang matuto ng Hadoop sa learnSpark . Spark ay isang malayang proyekto. Ngunit pagkatapos ng YARNAnd Hadoop 2.0, Spark naging tanyag dahil Spark maaaring tumakbo sa ibabaw ng HDFS kasama ng iba pa Hadoop mga bahagi. Hadoop ay isang balangkas kung saan isinusulat mo ang MapReduce ng trabaho sa pamamagitan ng pagmamana ng mga klase sa Java.

Katulad nito, alin ang mas mahusay na matuto ng spark o Hadoop?

Ang una at pangunahing pagkakaiba ay ang kapasidad ng RAM at paggamit nito. Spark gamit higit pa Random Access Memory kaysa Hadoop , ngunit ito ay "kumakain" ng mas kaunting halaga ng internet o disc memory, kaya kung gagamit ka Hadoop , ito ay mas mabuti upang makahanap ng isang malakas na makina na may malaking internalstorage.

Pangalawa, madaling matutunan ang Hadoop? Hadoop programming ay mas madali para sa mga taong may kasanayan din sa SQL - salamat sa Pig at Hive. Ang mga mag-aaral o mga propesyonal na walang anumang programming background, na may lamang basicSQL kaalaman, ay maaaring master Hadoop sa pamamagitan ng comprehensivehands-on Hadoop pagsasanay kung mayroon silang kasigasigan at pagnanais na matuto.

Tinanong din, gaano katagal bago matutunan ang Hadoop?

humigit-kumulang 3-4 na buwan

Pinapalitan ba ng spark ang Hadoop?

Spark hindi kailanman maaaring maging a kapalit para sa Hadoop ! Spark ay isang processing engine na gumagana sa tuktok ng Hadoop ecosystem. Tulad ng ipinakita sa itaas na arkitektura, Spark ay kapalit ng MapReduce sa Hadoop ecosystem. Mayroong iba pang mga sangkap sa Hadoop architecture upang iproseso ang data tulad ng Pig andHive.

Inirerekumendang:

Posible bang matuto ng python sa isang linggo?

Orihinal na Sinagot: Paano ako matututo ng Python sa isang linggo? Hindi mo kaya. Ang Python ay isang medyo simpleng wika, kaya maaari mong matutunan ang pangunahing syntax nito sa lalong madaling panahon. Gayunpaman, upang aktwal na makapag-program nang epektibo dito, kailangan mong makakuha ng sapat na dami ng karanasan sa pagsusulat ng software sa Python

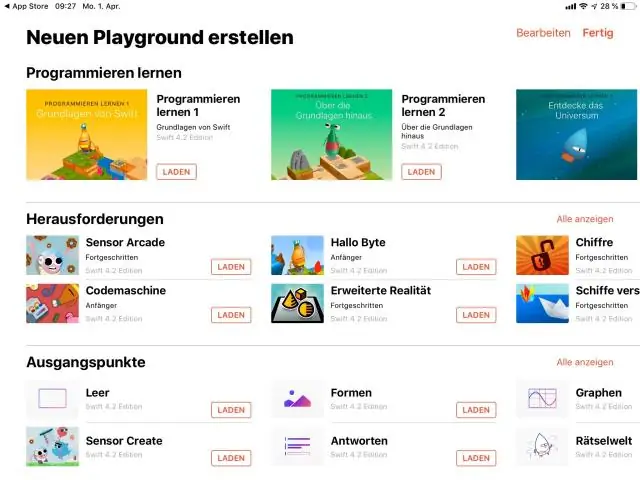

Maaari ka bang matuto ng coding sa isang iPad?

Alamin ang seryosong code sa iyong iPad. Ina seryoso masaya paraan. Ang Swift Playgrounds ay isang rebolusyonaryong app para sa iPad na ginagawang interaktibo at masaya ang pag-aaral ng Swift. Hindi ito nangangailangan ng kaalaman sa coding, kaya perpekto ito para sa mga mag-aaral na nagsisimula pa lang

Mahirap bang matuto ng C++ kung alam mo ang Java?

Ang C++ ay isang napakakomplikadong wika, higit sa lahat ay mas kumplikado kaysa sa Java, tulad nito, dinadala nito ang lahat ng mga tampok nito na mahirap matutunan. Hindi mo maaaring asahan na matuto ng C++ sa loob ng ilang linggo, o kahit na buwan. Kakailanganin mong matutunan kung paano haharapin ang pamamahala ng memorya. Ginagawa ng Java ang lahat ng pamamahala ng memorya para sa iyo, ngunit hindi ginagawa ng C++

Bakit kailangan nating matuto ng machine learning?

Ang umuulit na aspeto ng machine learning ay mahalaga dahil habang ang mga modelo ay nalantad sa bagong data, sila ay nakapag-iisa na makakaangkop. Natututo sila mula sa mga nakaraang pagkalkula upang makagawa ng maaasahan, paulit-ulit na mga desisyon at resulta. Ito ay isang agham na hindi bago – ngunit isa na nakakuha ng freshmomentum

Alin ang mas mahusay na matuto ng spark o Hadoop?

Hindi, hindi ipinag-uutos na matutunan muna ang Hadoop na matutunan ang Spark ngunit ang pangunahing kaalaman sa Hadoop at HDFS ay magdaragdag ng isang kalamangan sa iyong pag-aaral ng Spark. Ang Spark ay isang umuusbong na teknolohiya at isang buzz sa merkado. Ang Learning Spark ay magiging kapaki-pakinabang para sa iyong karera dahil ang mga propesyonal sa Spark ay mas ginusto sa industriya