Talaan ng mga Nilalaman:

- May -akda Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:54.

- Huling binago 2025-01-22 17:43.

Ang mga file ng Configuration na kailangang i-update upang mag-set up ng ganap na ipinamamahagi na mode ng Hadoop ay:

- Hadoop-env.sh.

- Core-site. xml.

- Hdfs-site. xml.

- Mapred-site. xml.

- Mga master.

- Mga alipin.

Bukod, ano ang mahahalagang configuration file sa Hadoop?

Ang configuration ng Hadoop ay hinihimok ng dalawang uri ng mahahalagang configuration file:

- Read-only na default na configuration - src/core/core-default. xml, src/hdfs/hdfs-default. xml at src/mapred/mapred-default. xml.

- Configuration na partikular sa site - conf/core-site. xml, conf/hdfs-site. xml at conf/mapred-site. xml.

Katulad nito, alin sa mga sumusunod ang naglalaman ng configuration para sa mga HDFS daemon? xml naglalaman ng pagsasaayos mga setting ng Mga daemon ng HDFS (ibig sabihin, NameNode, DataNode, Secondary NameNode). Kasama rin dito ang replication factor at block size ng HDFS.

ano ang mga configuration file sa Hadoop?

Mga File ng Configuration ay ang mga file na matatagpuan sa kinuhang alkitran. gz file sa atbp/ hadoop / direktoryo. Lahat Mga Configuration File sa Hadoop nakalista sa ibaba, 1) HADOOP -ENV.sh->>Tinutukoy nito ang mga variable ng kapaligiran na nakakaapekto sa JDK na ginagamit ni Hadoop Daemon (bin/ hadoop ).

Aling mga file ang tumatalakay sa maliliit na problema sa file sa Hadoop?

1) HAR ( Hadoop Archive) Mga file ay ipinakilala sa harapin ang maliit na isyu sa file . Ang HAR ay nagpakilala ng isang layer sa ibabaw ng HDFS , na nagbibigay ng interface para sa file pag-access. Gamit Hadoop utos ng archive, HAR mga file ay nilikha, na nagpapatakbo ng a MapReduce trabaho sa pag-iimpake ng mga file ina-archive sa mas maliit bilang ng HDFS file.

Inirerekumendang:

Ano ang mga pangunahing parameter ng pagsasaayos na kailangang tukuyin ng user upang patakbuhin ang trabaho sa MapReduce?

Ang pangunahing mga parameter ng configuration na kailangang tukuyin ng mga user sa framework ng “MapReduce” ay: Ang mga lokasyon ng input ni Job sa distributed file system. Ang lokasyon ng output ni Job sa distributed file system. Input na format ng data. Output format ng data. Klase na naglalaman ng function ng mapa. Klase na naglalaman ng reduce function

Gaano katagal ang isang ganap na patay na iPhone upang i-on?

Ikonekta ang iyong iPhone o iPad sa isang wall charger at hayaan itong mag-charge nang ilang sandali - bigyan ito ng labinlimang minuto, marahil. Kung ang baterya ay ganap na patay, hindi mo ito basta-basta maisaksak at asahan itong tumugon kaagad. Bigyan ito ng ilang minuto upang mag-charge at dapat itong i-on mismo

Alin ang ginagamit upang matukoy kung ang isang piraso ng data sa cache ay kailangang isulat pabalik sa cache?

Ipinapahiwatig din ng bit ang nauugnay na bloke ng memorya na nabago at hindi pa nai-save sa storage. Kaya, kung ang isang piraso ng data sa cache ay kailangang isulat pabalik sa cache ang maruming bit ay kailangang itakda 0. Dirtybit=0 ang sagot

Ano ang kulang sa iyong device ng mahahalagang pag-aayos sa seguridad at kalidad?

Miss Mahalagang Seguridad at Pag-aayos ng Kalidad sa Windows 10 1803/1809. Karaniwan, nag-i-install ang Windows 10 ng mga update nang mag-isa kung hindi ka pa huminto sa mga update at ang mga update na ito ay nauugnay sa seguridad upang mapanatiling ligtas ang iyong computer. Nawawala ang iyong device ng mahahalagang pag-aayos sa seguridad at kalidad. Ang ilang mga update na file ay nawawala o may mga problema

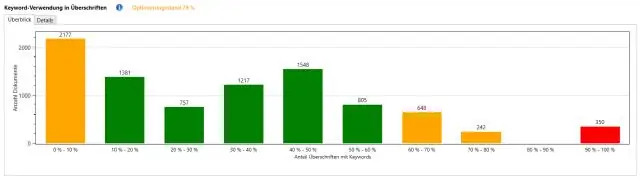

Ano ang mga lugar upang gamitin ang iyong mga keyword upang i-optimize ang ranggo ng website?

Ang isa sa mga pinakamahalagang lugar upang ma-optimize ang paggamit ng mga keyword sa SEO ay nasa iyong nilalaman. Para sa mas mahusay na ranggo ng web page, dapat mong gamitin ang mga keyword sa mga sumusunod na lugar: Keyword sa URL ng Website. Keyword sa Pamagat ng Website. Keyword sa Meta tag. Keyword sa nilalaman ng Web page. Densidad ng keyword sa body text. Mga Keyword sa Headlines