- May -akda Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:54.

- Huling binago 2025-06-01 05:11.

A Spark DataFrame ay isang distributed na koleksyon ng data na nakaayos sa mga pinangalanang column na nagbibigay ng mga operasyon upang i-filter, pangkatin, o pag-compute ang mga pinagsama-samang, at maaaring gamitin sa Spark SQL. DataFrames ay maaaring buuin mula sa mga structured na file ng data, mga kasalukuyang RDD, mga talahanayan sa Hive, o mga panlabas na database.

Katulad nito, maaari mong itanong, ano ang DataFrame sa Scala?

Isang ibinahagi na koleksyon ng data na nakaayos sa mga pinangalanang column. A Balangkas ng mga datos ay katumbas ng isang relational table sa Spark SQL. Upang pumili ng column mula sa balangkas ng mga datos , gamitin ang paraan ng paglalapat sa Scala at col sa Java.

ano ang gamit ng lit sa Scala? ( naiilawan ay ginamit sa Spark upang i-convert ang isang literal na halaga sa isang bagong column.) Dahil ang concat ay kumukuha ng mga column bilang mga argumento naiilawan dapat ginamit dito.

Sa tabi sa itaas, ano ang pagkakaiba sa pagitan ng RDD at DataFrame sa spark?

Spark RDD Mga API - Isang RDD ay kumakatawan sa Resilient Distributed Datasets. Ito ay Read-only partition collection ng mga record. RDD ay ang pangunahing istruktura ng data ng Spark . DataFrame sa Spark nagbibigay-daan sa mga developer na magpataw ng isang istraktura sa isang distributed na koleksyon ng data, na nagpapahintulot sa mas mataas na antas ng abstraction.

Ano ang ginagawa ng Column sa Spark?

Spark na may Column () function ay ginagamit upang palitan ang pangalan, baguhin ang halaga, i-convert ang datatype ng isang umiiral na column ng DataFrame at gayundin pwede gamitin para gumawa ng bagong column, sa post na ito, I kalooban gagabay sa iyo sa karaniwang ginagamit na mga operasyon ng column ng DataFrame na may Scala at mga halimbawa ng Pyspark.

Inirerekumendang:

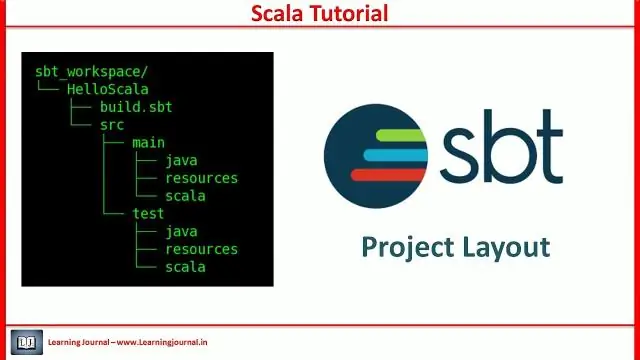

Ano ang proyekto ng SBT sa Scala?

Ang sbt ay isang open-source build tool para sa mga proyekto ng Scala at Java, katulad ng Maven at Ant ng Java. Ang mga pangunahing tampok nito ay: Native na suporta para sa pag-compile ng Scala code at pagsasama sa maraming Scala test frameworks. Patuloy na compilation, pagsubok, at deployment

Ano ang mga artista sa Scala?

Ang pangunahing concurrency ng Scala ay ang mga aktor. Ang mga aktor ay karaniwang magkakasabay na proseso na nakikipag-usap sa pamamagitan ng pagpapalitan ng mga mensahe. Ang mga aktor ay makikita rin bilang isang anyo ng mga aktibong bagay kung saan ang paggamit ng isang pamamaraan ay tumutugma sa pagpapadala ng mensahe

Ano ang RDD sa Scala?

Ang Resilient Distributed Datasets (RDD) ay isang pangunahing istruktura ng data ng Spark. Ito ay isang hindi nababagong ibinahagi na koleksyon ng mga bagay. Maaaring maglaman ang mga RDD ng anumang uri ng mga bagay na Python, Java, o Scala, kabilang ang mga klase na tinukoy ng user. Sa pormal, ang isang RDD ay isang read-only, nahati na koleksyon ng mga tala

Ano ang override sa Scala?

Pamamaraan ng Scala Overriding. Kapag ang isang subclass ay may parehong paraan ng pangalan gaya ng tinukoy sa parent class, ito ay kilala bilang method overriding. Kapag nais ng subclass na magbigay ng isang partikular na pagpapatupad para sa pamamaraang tinukoy sa parent class, i-override nito ang pamamaraan mula sa parent class

Ano ang implicit class sa Scala?

Ipinakilala ng Scala 2.10 ang isang bagong tampok na tinatawag na mga implicit na klase. Ang implicit class ay isang klase na minarkahan ng implicit na keyword. Ginagawa ng keyword na ito na available ang pangunahing constructor ng klase para sa mga implicit na conversion kapag nasa saklaw ang klase. Ang mga implicit na klase ay iminungkahi sa SIP-13