- May -akda Lynn Donovan [email protected].

- Public 2023-12-15 23:54.

- Huling binago 2025-01-22 17:43.

Pag-ingest ng data ay ang proseso ng pagkuha at pag-import datos para sa agarang paggamit o imbakan sa isang database. Ang pag-ingest ng isang bagay ay "kumuha ng isang bagay o sumipsip ng isang bagay." Data maaaring i-stream sa real time o kinain sa mga batch.

Alamin din, ano ang pipeline ng ingestion ng data?

Data Ingestion Pipeline . A pipeline ng pag-ingest ng data gumagalaw streaming datos at batched datos mula sa mga dati nang database at datos mga bodega sa a datos lawa. Para sa isang HDFS-based datos lawa, ginagamit ang mga tool gaya ng Kafka, Hive, o Spark pag-ingest ng data . Si Kafka ay isang sikat pag-ingest ng data tool na sumusuporta sa streaming datos.

Higit pa rito, paano nakakakuha ng data ang Hadoop? Hadoop gumagamit ng distributed file system na na-optimize para sa pagbabasa at pagsulat ng malalaking file. Kapag sumulat sa HDFS , datos ay "hiniwa" at ginagaya sa mga server sa a Hadoop kumpol. Ang proseso ng paghiwa ay lumilikha ng maraming maliliit na sub-unit (mga bloke) ng mas malaking file at malinaw na isinusulat ang mga ito sa mga cluster node.

Pangalawa, ano ang mga tool sa ingestion ng data?

Mga tool sa pag-ingest ng data magbigay ng balangkas na nagpapahintulot sa mga kumpanya na mangolekta, mag-import, mag-load, maglipat, magsama, at magproseso datos mula sa isang malawak na hanay ng datos pinagmumulan. Pinapadali nila ang datos proseso ng pagkuha sa pamamagitan ng pagsuporta sa iba't ibang datos mga protocol ng transportasyon.

Ano ang iyong pagkaunawa sa data ingestion at integration?

Pag-ingest ng data ay ang proseso ng pag-ingest ng data mula sa isang sistema patungo sa isa pa. Pagsasama ng data nagbibigay-daan sa iba't ibang datos mga uri (tulad ng datos set, dokumento at talahanayan) na isasama at gagamitin ng mga aplikasyon para sa mga proseso ng personal o negosyo.

Inirerekumendang:

Ano ang isang malaking sistema ng data?

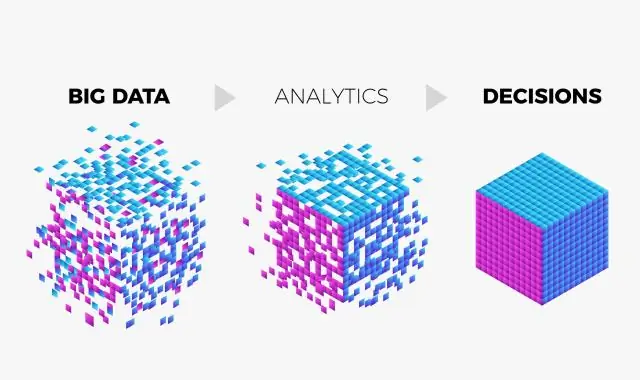

Binubuo ang malaking data system ng mga mandatoryong feature na Data, Data Storage, Information Management, Data Analysis, Data Processing, Interface at Visualization, at ang opsyonal na feature, System Orchestrator

Ano ang ginagawa ng Google sa malaking data?

Ang sagot ay Big data analytics. Gumagamit ang Google ng mga tool at diskarte sa Big Data upang maunawaan ang aming mga kinakailangan batay sa ilang parameter tulad ng history ng paghahanap, lokasyon, trend atbp

Ano ang Impala sa malaking data?

Ang Impala ay isang open source na massively parallel processing query engine sa itaas ng mga clustered system tulad ng Apache Hadoop. Nilikha ito batay sa Dremel paper ng Google. Ito ay isang interactive na SQL tulad ng query engine na tumatakbo sa ibabaw ng Hadoop Distributed File System (HDFS). Ginagamit ng Impala ang HDFS bilang pinagbabatayan nitong imbakan

Ano ang mga V ng malaking data?

Sa karamihan ng malalaking grupo ng data, ang mga ito ay tinatawag na apat na V's: volume, variety, velocity, at veracity. (Maaari mong isaalang-alang ang ikalimang V, halaga.)

Ano ang use case sa malaking data?

Bagama't ang karamihan sa mga kaso ng paggamit ng malaking data ay tungkol sa pag-iimbak at pagpoproseso ng data, sumasaklaw ang mga ito sa maraming aspeto ng negosyo, gaya ng analytics ng customer, pagtatasa ng panganib at pagtuklas ng panloloko. Kaya, mahahanap ng bawat negosyo ang nauugnay na kaso ng paggamit upang matugunan ang kanilang mga partikular na pangangailangan