- May -akda Lynn Donovan [email protected].

- Public 2023-12-15 23:54.

- Huling binago 2025-01-22 17:43.

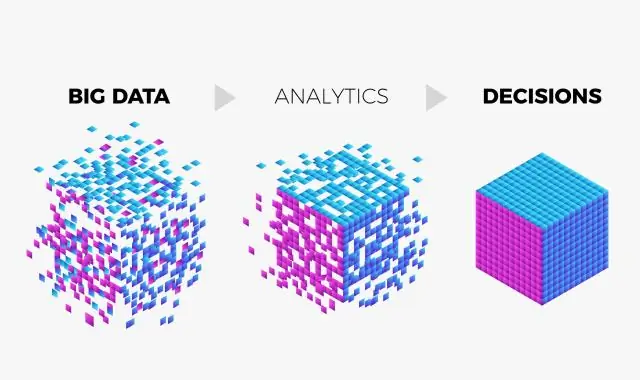

Big data ang sagot pagsusuri . Gumagamit ang Google ng mga tool at diskarte sa Big Data upang maunawaan ang aming mga kinakailangan batay sa ilang parameter tulad ng history ng paghahanap, lokasyon, trend atbp.

Bukod dito, paano pinangangasiwaan ng Google ang malaking data?

ng Google Mesa ay isang datos warehousing environment na nagpapagana sa karamihan ng Google ecosystem. Sa pamamagitan ng kanilang mahabang karanasan sa advertising sa internet. Mesa humahawak petabytes ng datos , nagpoproseso ng milyun-milyong row update sa bawat segundo, at naghahatid ng bilyun-bilyong query na kumukuha ng trilyong row bawat araw.

Maaari ding magtanong, paano ginagamit ng Google ang data? Nangongolekta ito datos sa kung anong mga video ang pinapanood mo, ang mga ad na na-click mo, ang iyong lokasyon, impormasyon ng device, at IP address at cookie datos . Sinasabi nito na ginagawa nito ito upang “gawing mas mahusay ang mga serbisyo [nito] para sa iyo, na totoo: Kung haharangin mo ang lahat ng bagay, iba-block mo rin ng Google kakayahang magpakita sa iyo ng higit pang nilalamang sa tingin nito ay magugustuhan mo.

Pangalawa, ano ang cloud computing para sa malaking data?

Ang pangunahing pokus ng Cloud computing ay upang magbigay ng mga mapagkukunan at serbisyo ng computer sa tulong ng koneksyon sa network. Habang malaking data ay tungkol sa paglutas ng mga problema kung kailan isang malaking halaga ng mga datos pagbuo at pagproseso. Sa Cloud computing , ang datos ay naka-imbak sa mga server na pinananatili ng iba't ibang mga service provider.

Ang isang ganap na pinamamahalaang low cost serverless data warehouse na sumasaklaw sa iyong mga pangangailangan sa storage at computing power?

Ang BigQuery ay sa Google ganap na pinamamahalaan , mura , walang server na data warehouse na sumasaklaw sa iyong mga pangangailangan sa storage at computing power . Sa BigQuery, makakakuha ka ng columnar at ANSI SQL database na makakapagsuri ng mga terabyte hanggang sa mga petabyte datos sa napakabilis na bilis.

Inirerekumendang:

Ano ang data ingestion sa malaking data?

Ang data ingestion ay ang proseso ng pagkuha at pag-import ng data para sa agarang paggamit o imbakan sa isang database. Ang pag-ingest ng isang bagay ay ang 'kumuha ng isang bagay o sumipsip ng isang bagay.' Ang data ay maaaring i-stream sa real time o ingested sa mga batch

Ano ang isang malaking sistema ng data?

Binubuo ang malaking data system ng mga mandatoryong feature na Data, Data Storage, Information Management, Data Analysis, Data Processing, Interface at Visualization, at ang opsyonal na feature, System Orchestrator

Ano ang Impala sa malaking data?

Ang Impala ay isang open source na massively parallel processing query engine sa itaas ng mga clustered system tulad ng Apache Hadoop. Nilikha ito batay sa Dremel paper ng Google. Ito ay isang interactive na SQL tulad ng query engine na tumatakbo sa ibabaw ng Hadoop Distributed File System (HDFS). Ginagamit ng Impala ang HDFS bilang pinagbabatayan nitong imbakan

Ano ang mga V ng malaking data?

Sa karamihan ng malalaking grupo ng data, ang mga ito ay tinatawag na apat na V's: volume, variety, velocity, at veracity. (Maaari mong isaalang-alang ang ikalimang V, halaga.)

Ano ang use case sa malaking data?

Bagama't ang karamihan sa mga kaso ng paggamit ng malaking data ay tungkol sa pag-iimbak at pagpoproseso ng data, sumasaklaw ang mga ito sa maraming aspeto ng negosyo, gaya ng analytics ng customer, pagtatasa ng panganib at pagtuklas ng panloloko. Kaya, mahahanap ng bawat negosyo ang nauugnay na kaso ng paggamit upang matugunan ang kanilang mga partikular na pangangailangan